关联视频

关于 Obsidian Copilot 插件的介绍我写过不少文章,不过之前使用的 API 都是硅基流动 或者 OpenRouter 提供的,如果追求绝对的隐私,那用这些 API 还是不够。

所以今天我们来试试本地离线的 Ollama,并配置 Obsidian Copilot 插件,享受安全、可控的 AI 体验。

下载安装 Ollama

- 官网:https://ollama.com/download

- 下载 Ollama 后,解压缩然后安装程序

下载模型

因为是在本地部署大模型,所以你需要注意的是,并不是每个人都可以成功部署,这个跟你的电脑配置(主要是显卡显存)有关。

这里我们就先选择下载配置比较适中的 qwen2.5:14b 模型, 下载方法如下。

- Mac 用户请打开终端(用 Spotlight 搜索),Windows 用户在「开始」菜单里找到 CMD 命令提示符,然后打开。

- 在命令窗口中输入代码

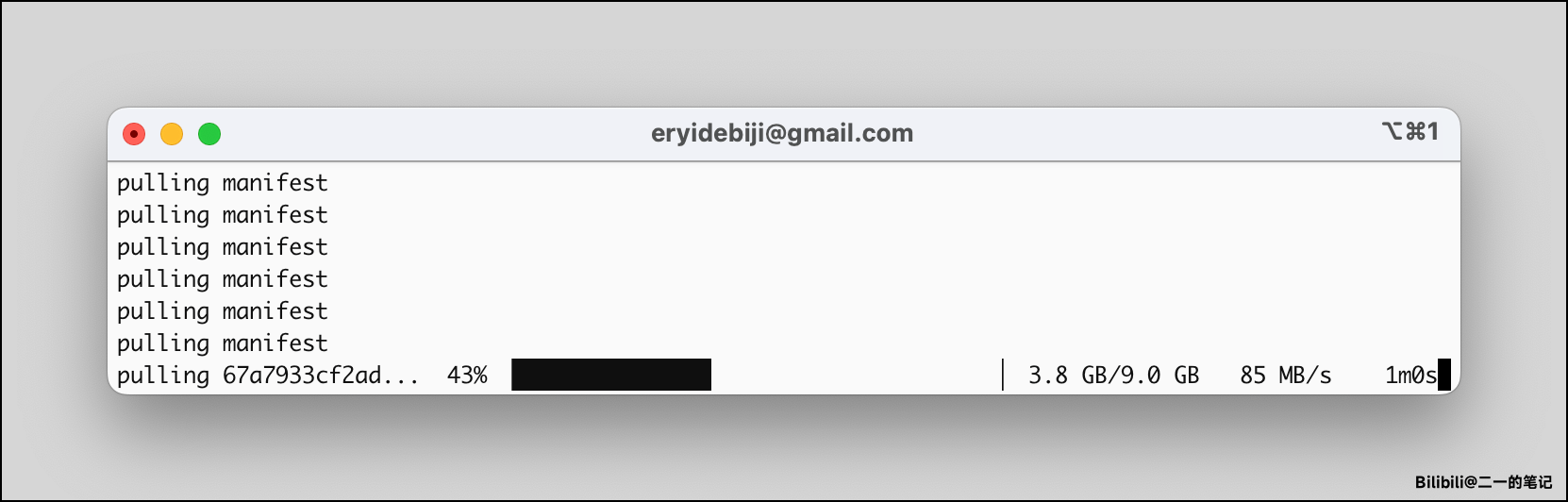

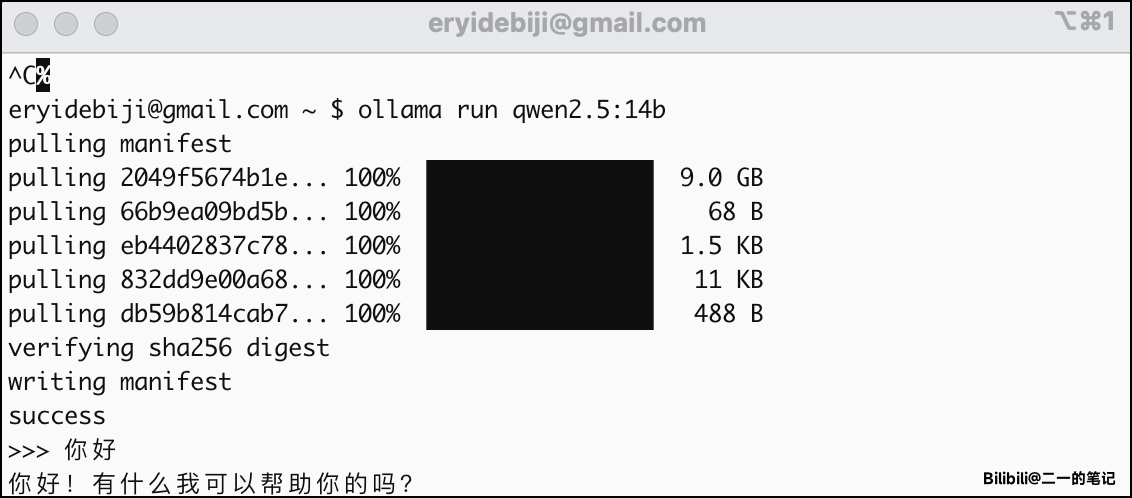

ollama run qwen2.5:14b然后回车 - 这个时候就会自动下载这个模型,请稍作等待,等进度条走到 100%

- 安装完毕后,你就可以直接在这个命令窗口中,跟这个大模型对话了。如果能正确回答你的问题,则说明安装成功,并且模型可用。

- 第四步确认安装完毕后,我们先输入

/bye命令,退出这个模型 - 接下来安装嵌入模型,在命令窗口输入命令

ollama pull bge-m3回车,然后等待安装完成 - 再输入

/bye命令,退出安装过程,然后关闭退出 ollama 应用程序

配置 Copilot 插件

- 使用命令

OLLAMA_ORIGINS=app://obsidian.md* ollama serve重新启动 Ollama - 打开 Copilot 插件的设置页面

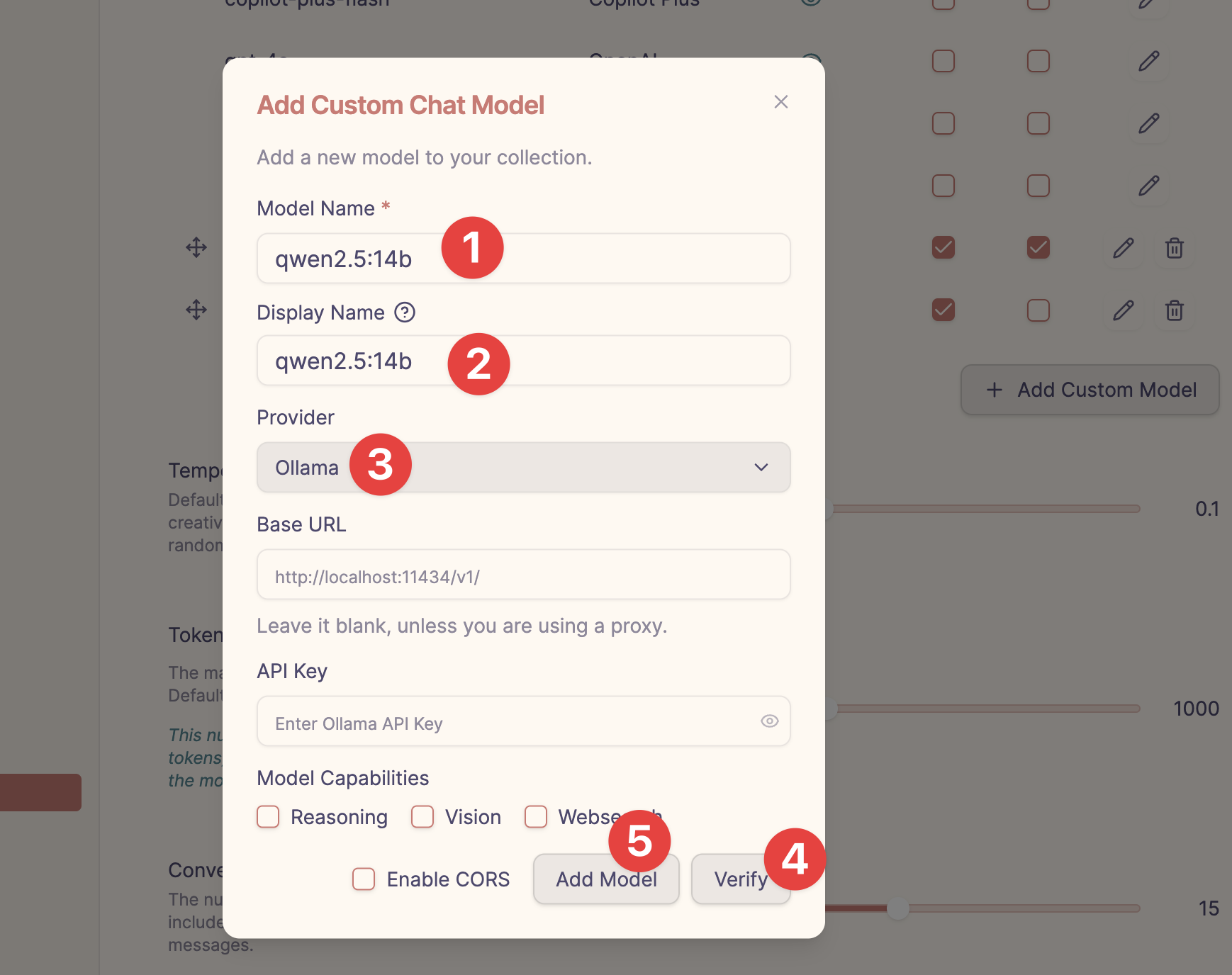

- 按照下图所示填写

- 在 Model Name 填写

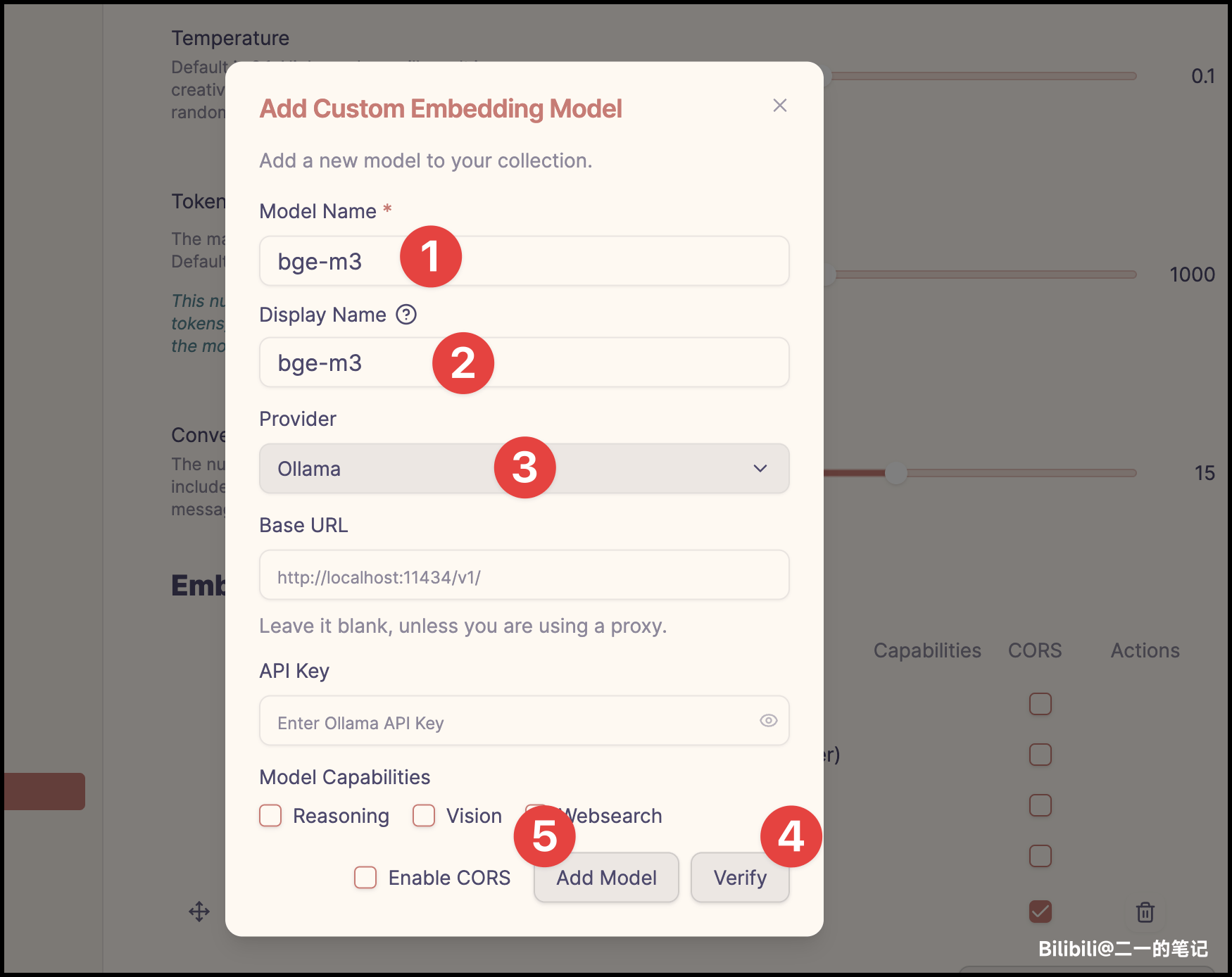

qwen2.5:14b - Display Name 可以自定义

- 先点击 Verify 按钮,确认模型可用

- 然后再点击 Add Model

- 在 Model Name 填写

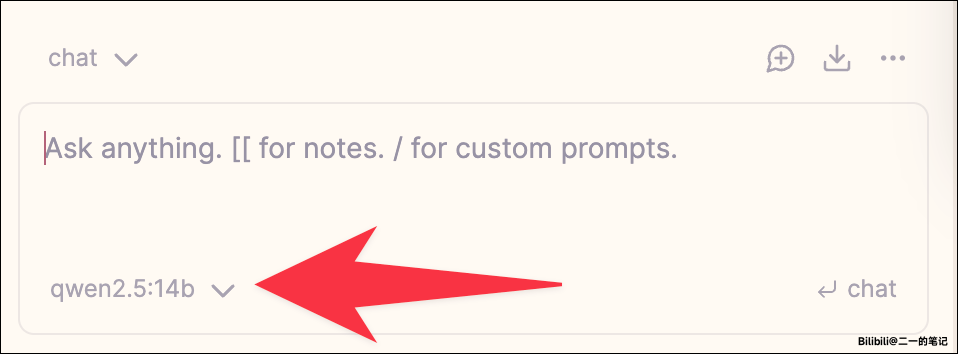

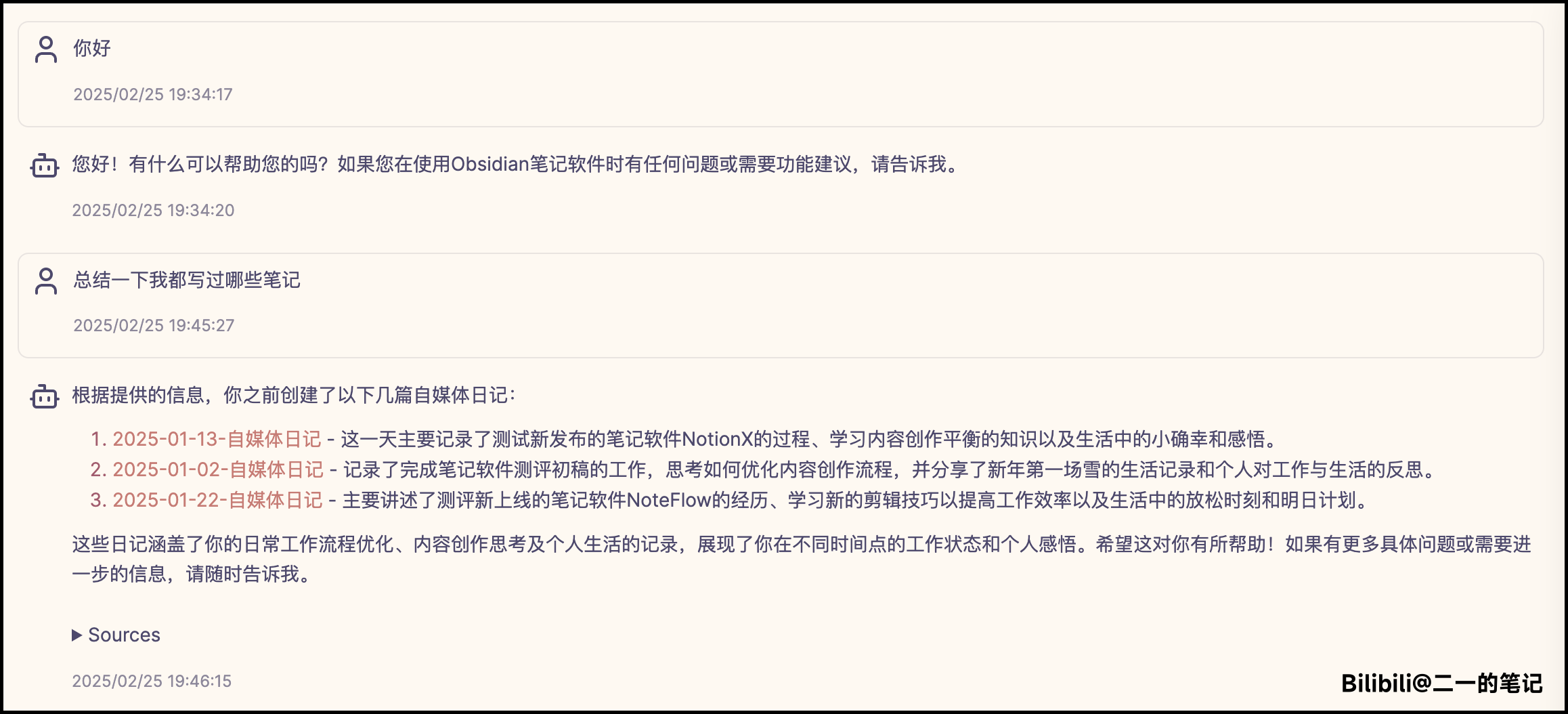

- 添加完模型后,就可以在 Copilot 的插件问答窗口,使用这个本地模型来进行问答了

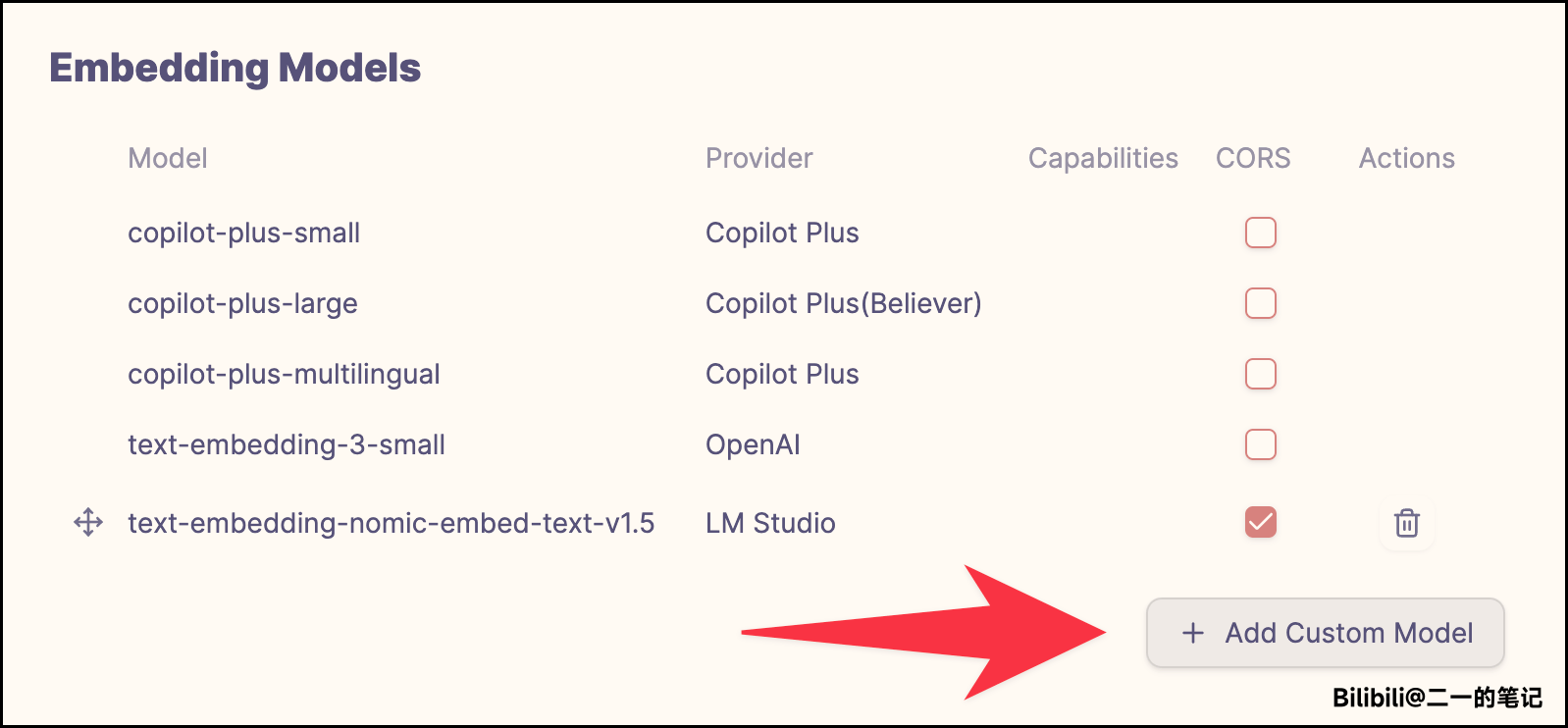

- 用同样的方法,我们也可以给 Copilot 插件配置本地的嵌入模型。在 Copilot 设置页面的 Embedding Models 位置,找到 Add Custom Model 按钮

- 按照下图所示填写

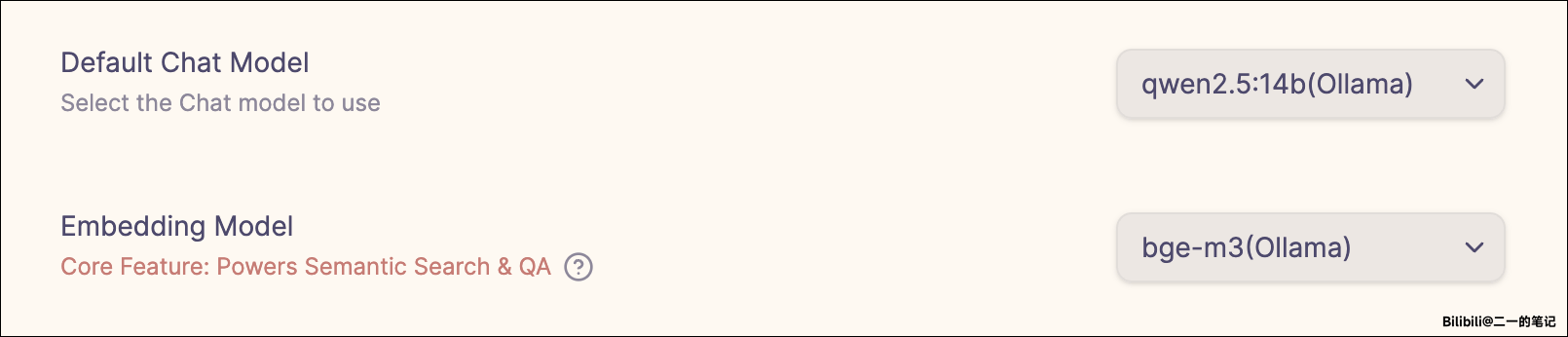

- 回到 Copilot 的 Basic 设置页面,可以在下图所示位置,将问答模型与嵌入模型修改为我们刚才本地部署的两个模型

配置完毕,撒花!

关联文章

- 在 Obsidian 中集成 AI 问答功能:Obsidian Copilot + DeepSeek 设置教程

- M1 Max 用 Ollama 部署 qwen 2.5 大模型的简单记录

- LM Studio 教程:在 MacBook M1 上运行通义千问 Qwen 2.5 模型

关联视频

本站所有文章,除非特别说明或标注,均为本站原创发布。转载本文需附上本文链接,未经授权,禁止大篇幅复制、盗用、采集或发布本站内容至其他网站、书籍等各类媒体平台。