关联视频

Copilot 的 vault QA 是什么

在上一篇文章中,我介绍了 Obsidian Copilot 插件搭配 DeepSeek API 的设置教程,不过该篇文章末尾我遗留了一个问题,即 Copilot 的 Vault QA 设置方法。

在没有 vault QA 之前,我们虽然可以在 AI 对话窗口里,和指定的 AI 模型对话,或者让它根据某一篇指定的文章来回答问题,但是暂时还达不到 RAG 的效果,即无法让 Copilot 根据整个笔记库的资料来回答你的问题。

所以本文就要来解决这个遗留的问题。

设置方法

下载 LM Studio

具体方法在这篇文章《LM Studio 设置教程》已经有介绍过,本文就不再赘述。

下载嵌入模型

为了让 Copilot 能够「理解」你的笔记库,就需要先用嵌入模型将「文本」降维成 AI 可以理解的「数字向量」,而这就需要嵌入模型的帮助。

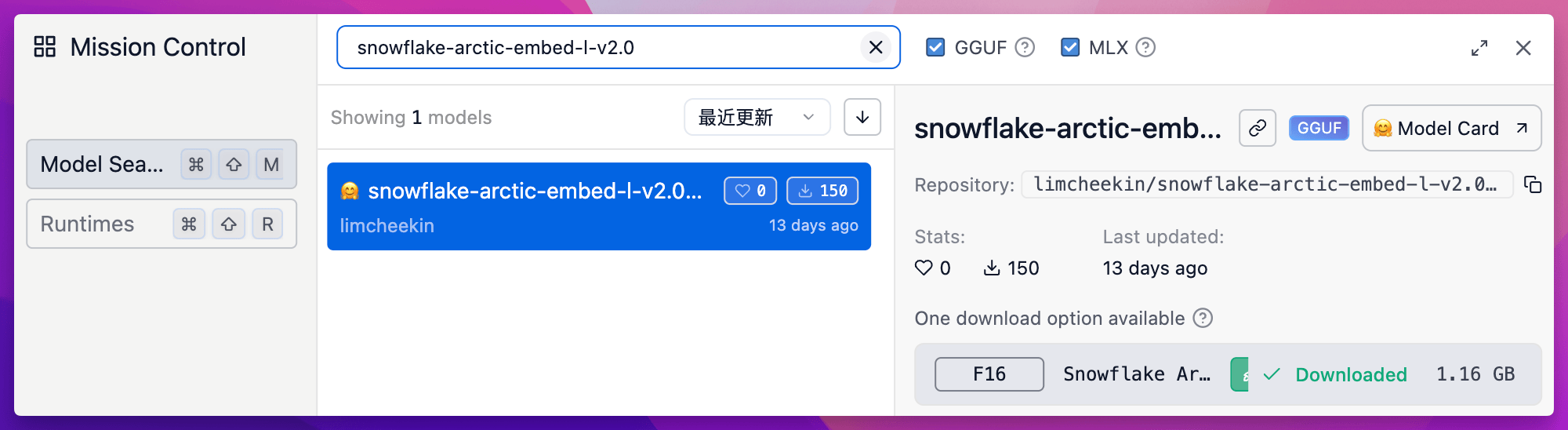

这里我选择 HuggingFace 上下载排名比较靠前的 snowflake-arctic-embed-l-v2.0 模型,直接在 LM Studio 搜索 snowflake-arctic-embed-l-v2.0 即可下载。

下载完成后,根据下图所示操作,载入这个模型

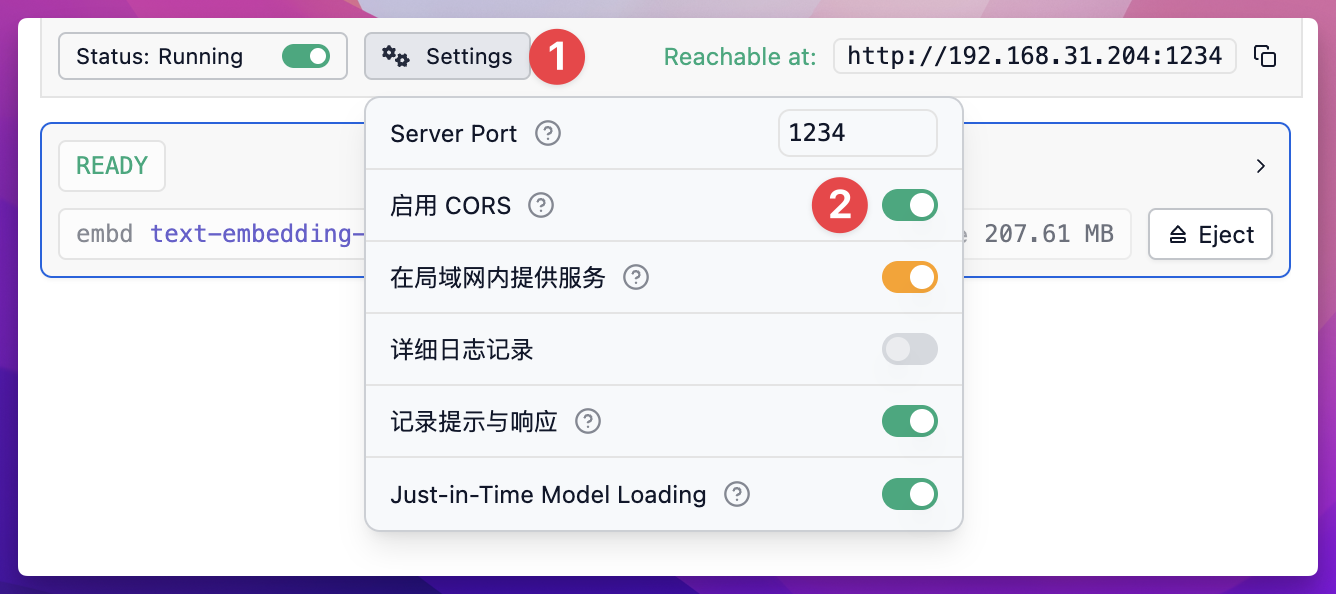

然后点击 Settings 按钮,开启 CORS 功能

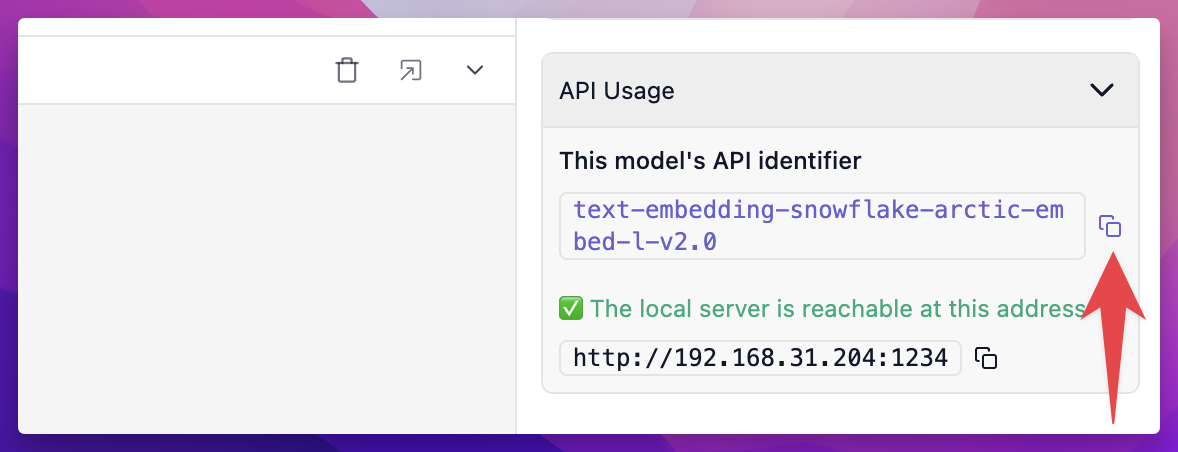

在 LM Studio 的右下角,找到并复制这个模型的完整名称,之后有用

配置 Copilot 嵌入模型

打开 Copilot 插件的设置页面,往下滑找到 QA Settings 这个模块

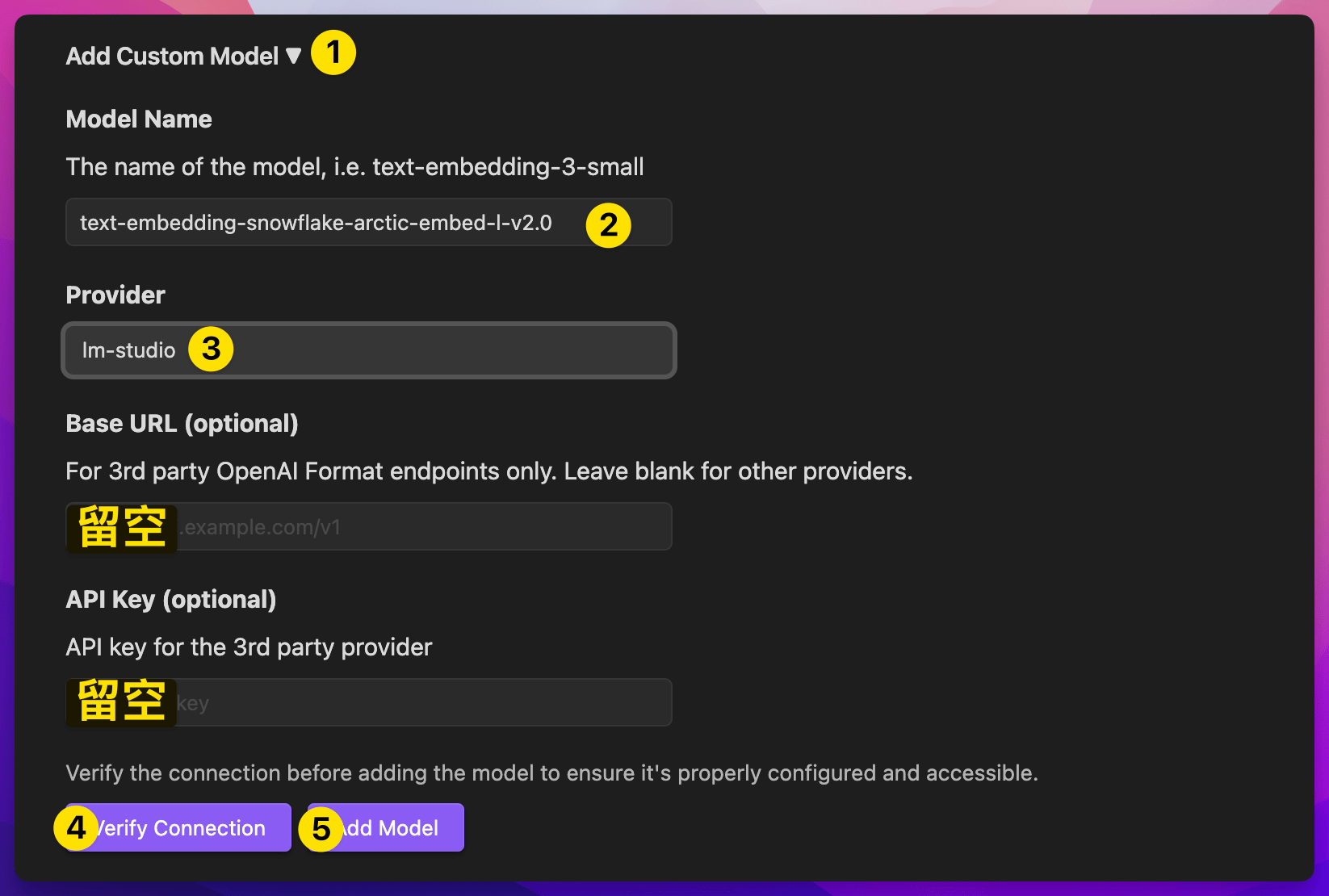

然后点击下方的 Add Custom Model 按钮,按照下图所示进行设置,

- 步骤 2 的模型名称是上一个步骤中,在 LM Studio 获得的

- 步骤 4 ,验证一下是否连接成功,成功的话,Obsidian 窗口的右上角会弹出提示

Model connection verified successfully!。 - 步骤 5 ,点击 Add model 按钮,添加这个模型。

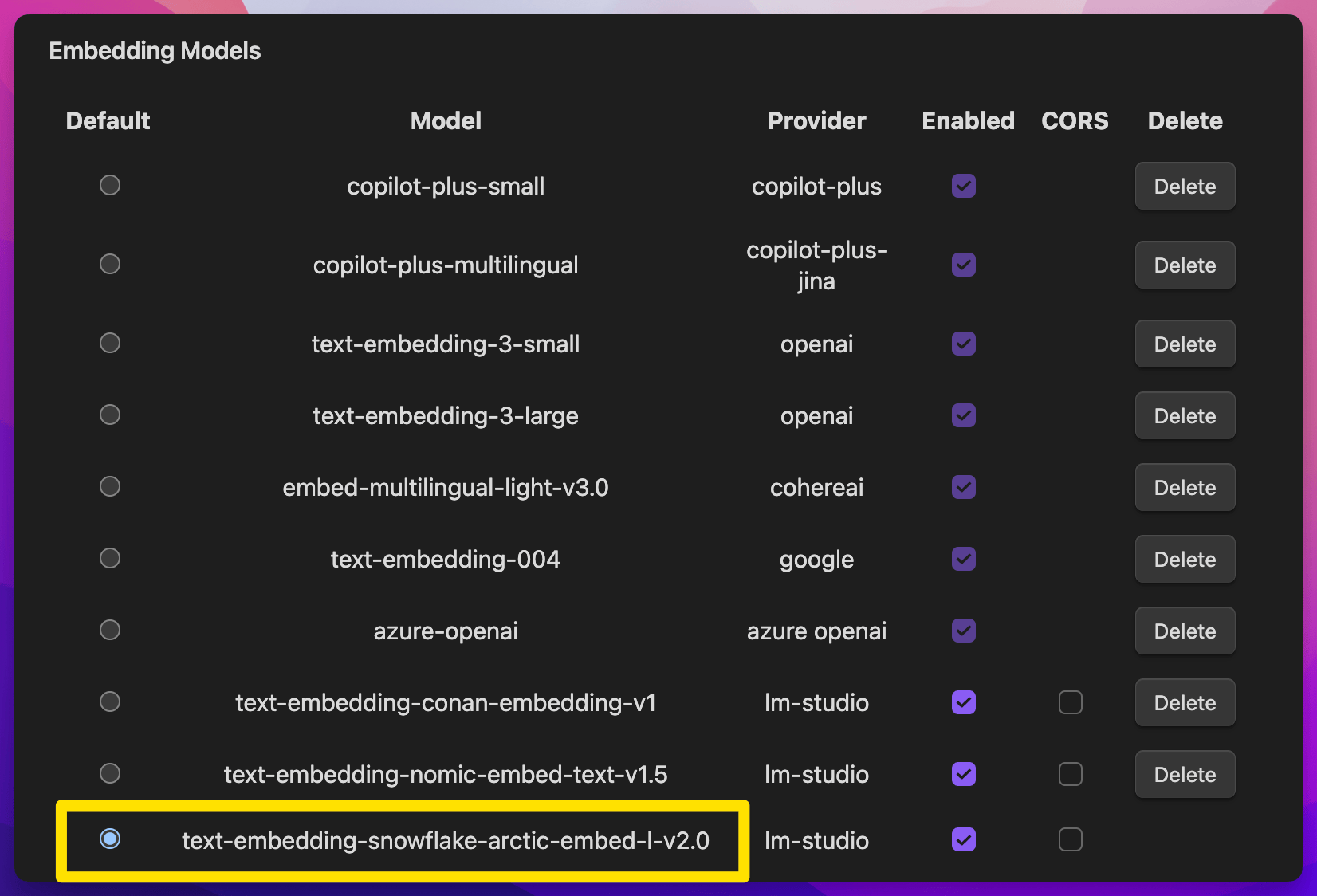

然后往上滑,找到 Embedding Models 这个模块,你会发现刚才添加的模型出现在的最底部

然后点击左侧的小圆圈,会弹出提示,点击 Continue 即可。

索引笔记库

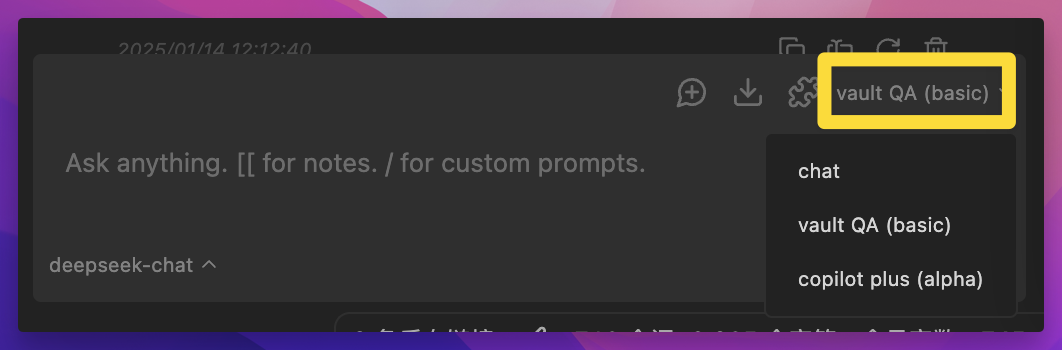

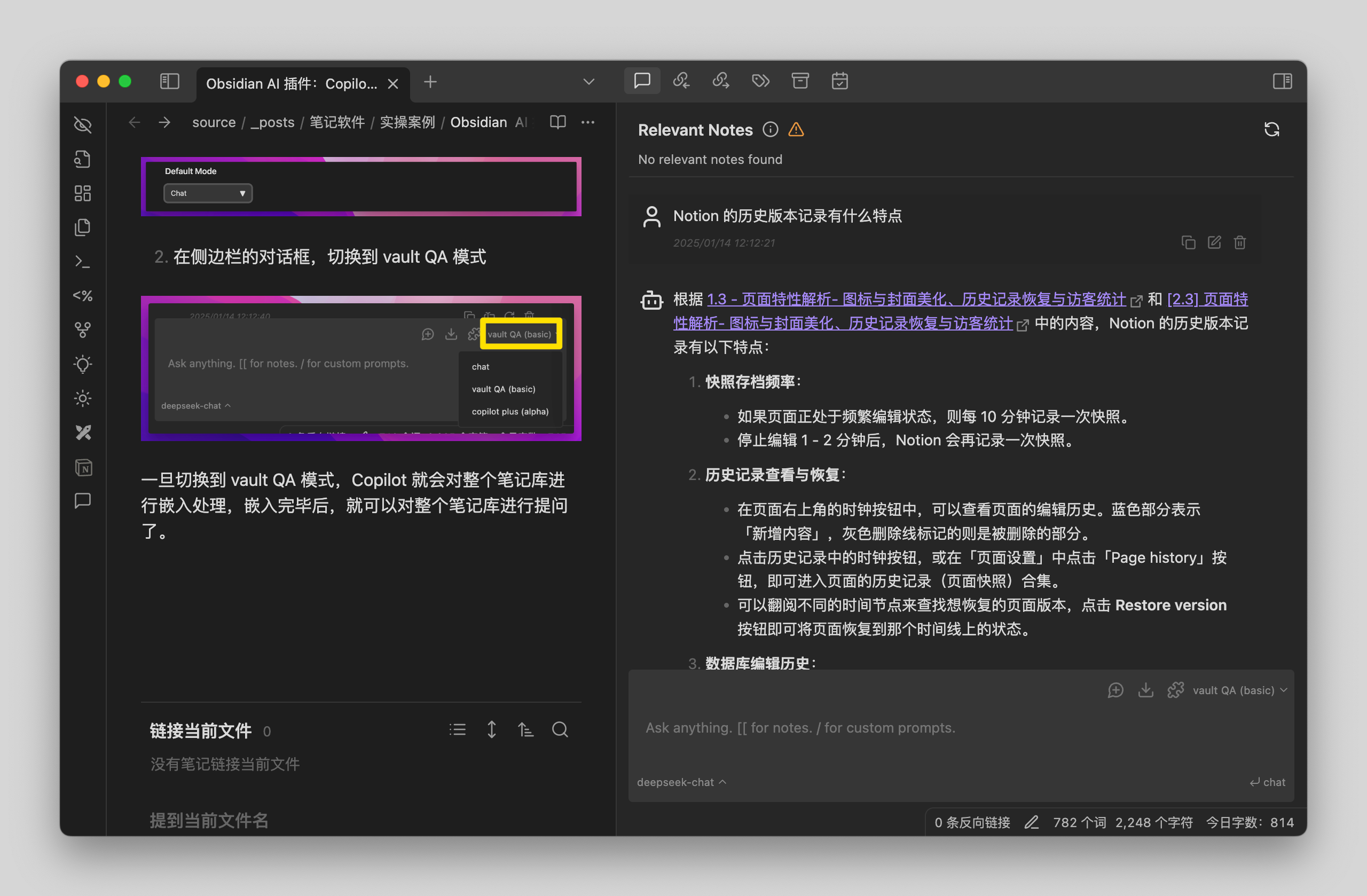

在默认情况下,Copilot 插件是 Chat 模式,如果你想切换到数据库问答模式,即 vault QA 模式,有两种切换方式。

- 在 Copilot 插件的这个位置,设定你想要的默认模式

- 在侧边栏的对话框,切换到 vault QA 模式

一旦切换到 vault QA 模式,Copilot 就会对整个笔记库进行嵌入处理,嵌入完毕后,就可以对整个笔记库进行提问了。

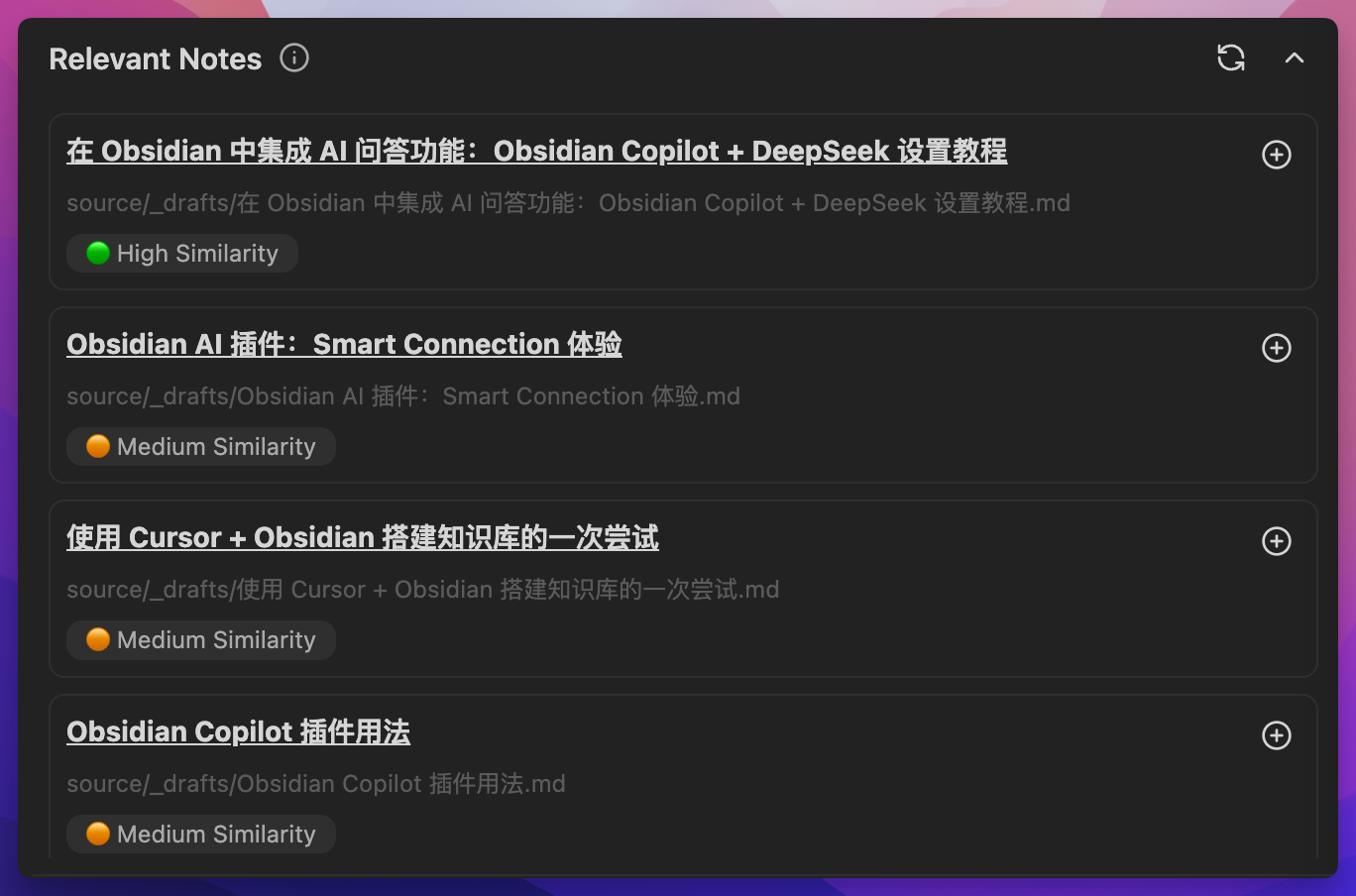

并且打开一篇笔记后,Copilot 还会自动列出与当前笔记相关的其他笔记,即 Relevant Notes

关联阅读

- 在 Obsidian 中集成 AI 问答功能:Obsidian Copilot + DeepSeek 设置教程

- LM Studio 教程:在 MacBook M1 上运行通义千问 Qwen 2.5 模型

- 最强 AI 大纲笔记软件,Tana 能否超越 Notion

- Obsidian 的 8 种用法

- 最强 AI 大纲笔记软件,Tana 能否超越 Notion

关联视频

本站所有文章,除非特别说明或标注,均为本站原创发布。转载本文需附上本文链接,未经授权,禁止大篇幅复制、盗用、采集或发布本站内容至其他网站、书籍等各类媒体平台。