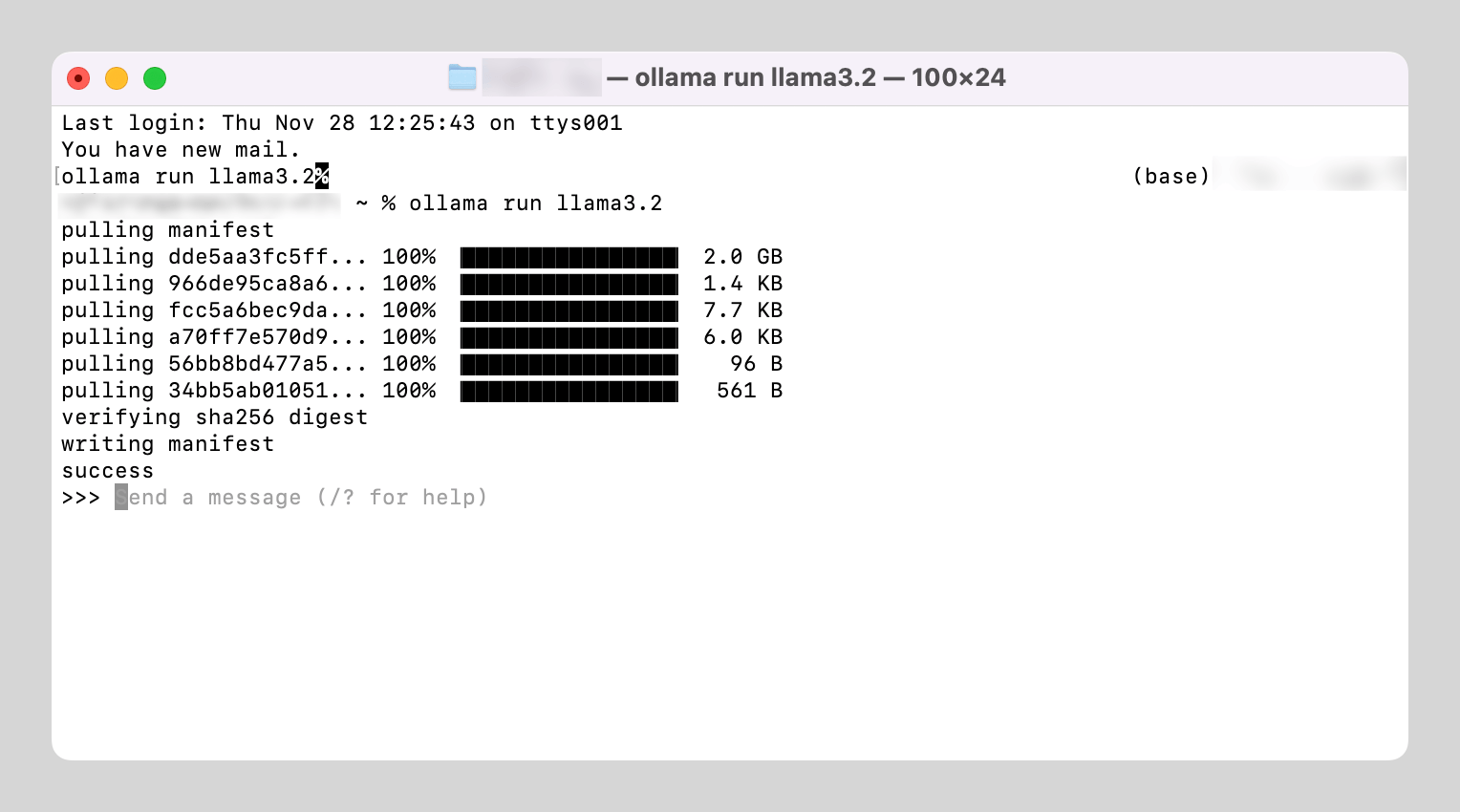

安装 Ollama

- 官网:https://ollama.com/download

- 下载后解压缩,然后安装程序

- 按照提示,在 Mac 终端内输入命令,即可自动完成安装与配置

- 随后点击 Ollama 应用程序图标, 启动运行

安装 webui

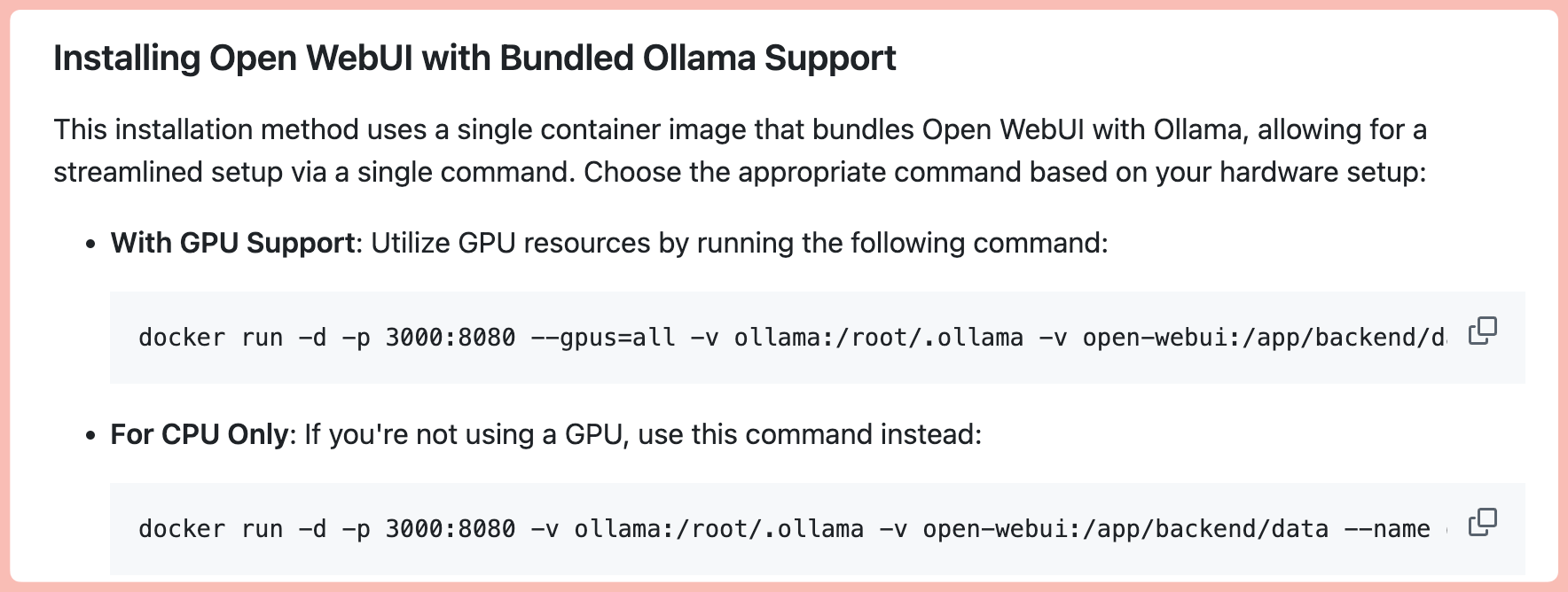

使用 Docker 安装 open webui

- 下载并安装 Docker:https://www.docker.com/

- 启动并运行 Docker

我的系统是 M1 Max ,所以使用下面的终端命令进行安装:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama其他系统需要参考这个项目里的说明:

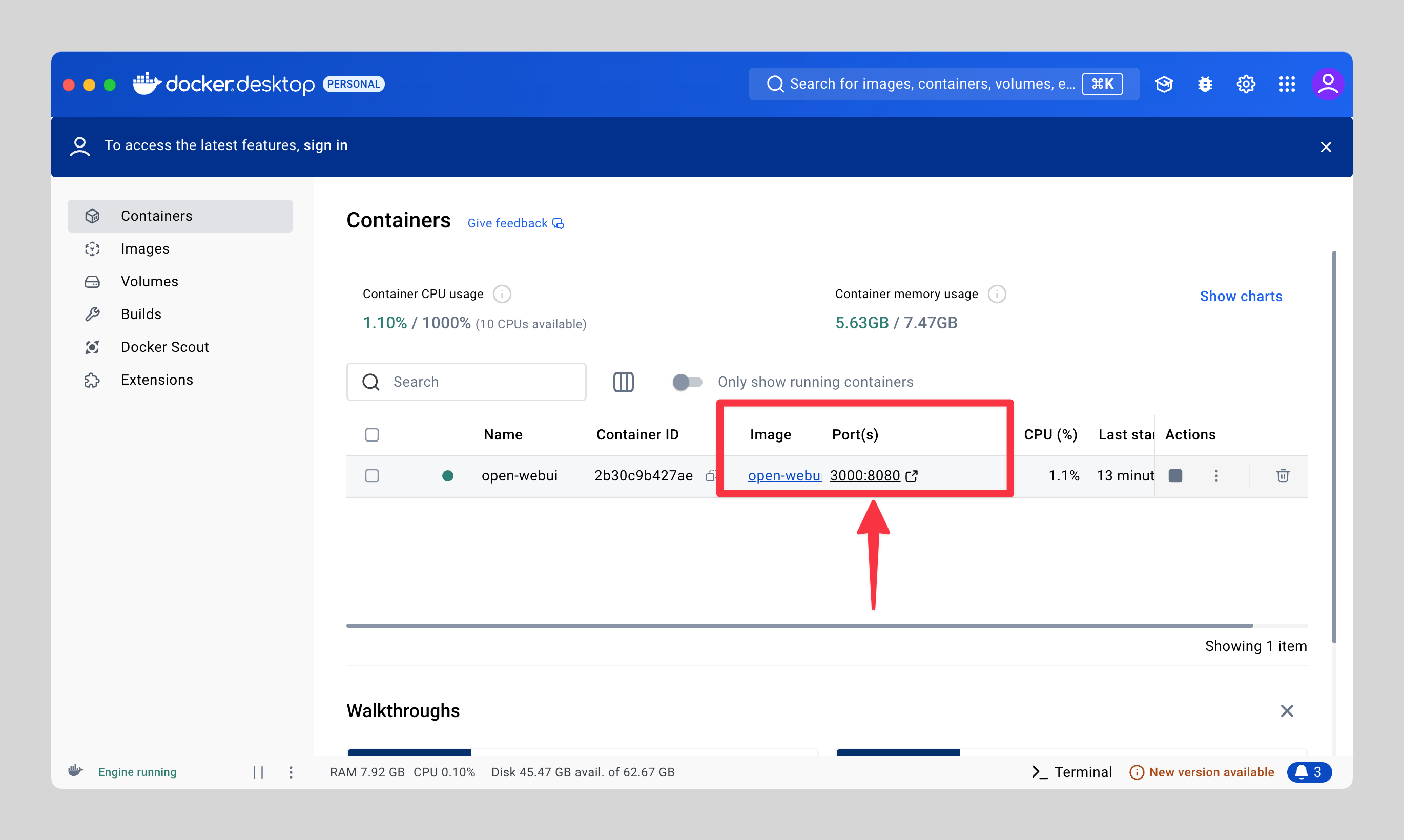

等命令走完之后,在 Docker 中启动 webui

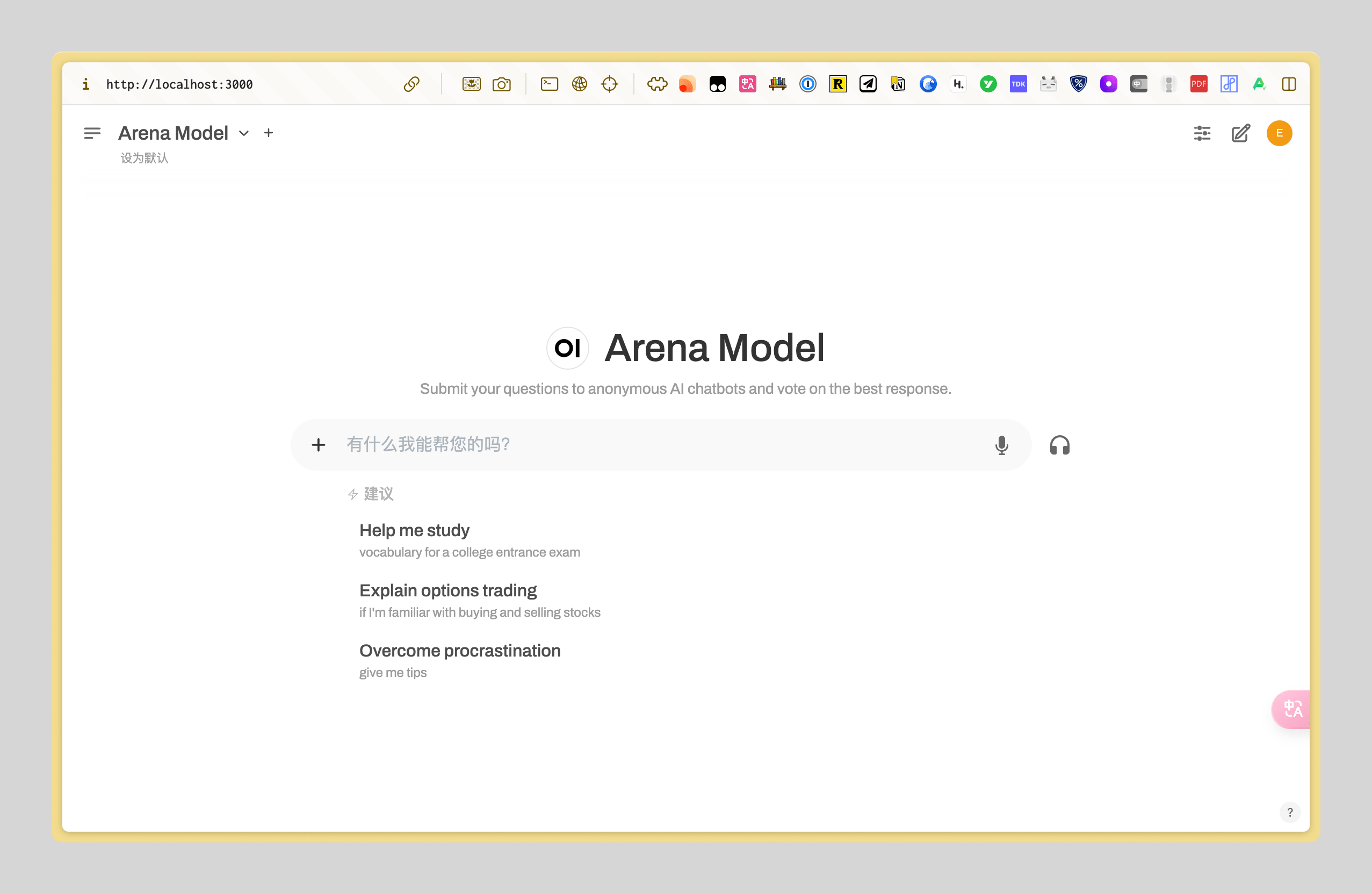

点击之后,就会出现类似 ChatGPT 一样的窗口

下载并使用通义千问 Qwen 2.5 模型

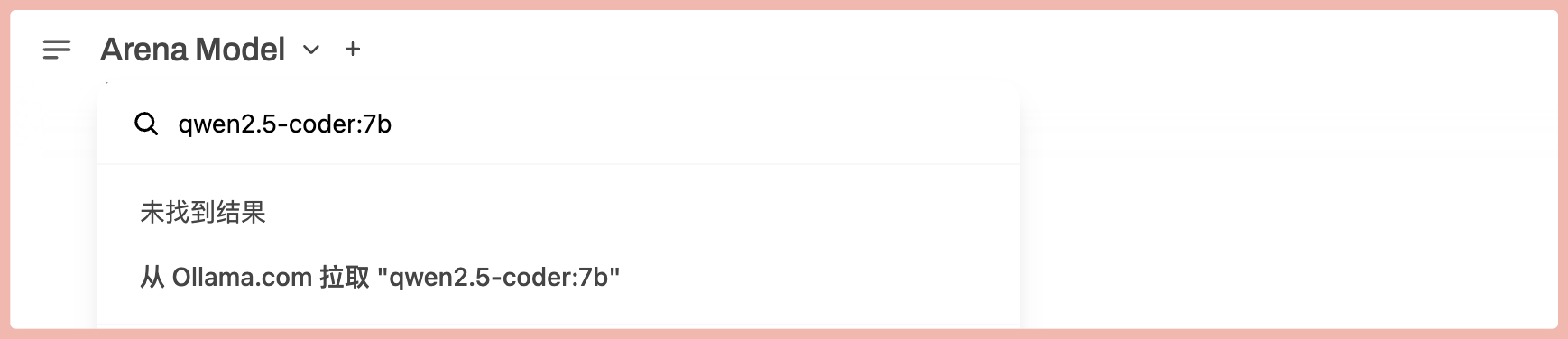

在 webui 的左上角中,搜索 qwen2.5-coder:7b ,然后点击「从 Ollama.com 拉取」

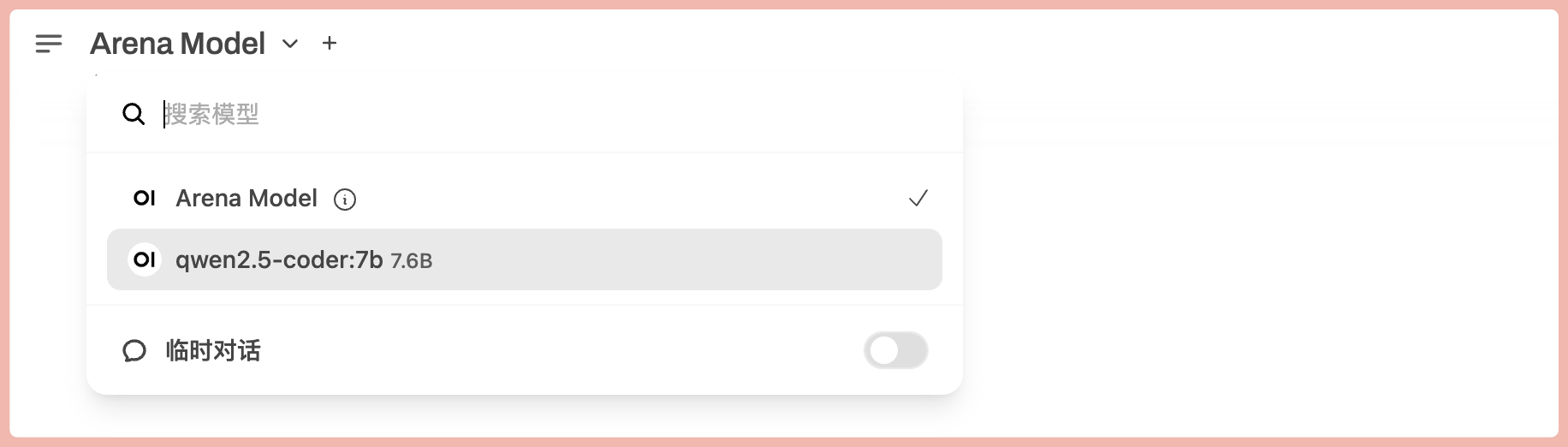

等待下载完毕后,就可以选择 Qwen 2.5 的 7b 模型。如果你想下载小一点的例如 3b 的模型,只需要把 qwen2.5-coder:7b 改成 qwen2.5-coder:3b 即可。

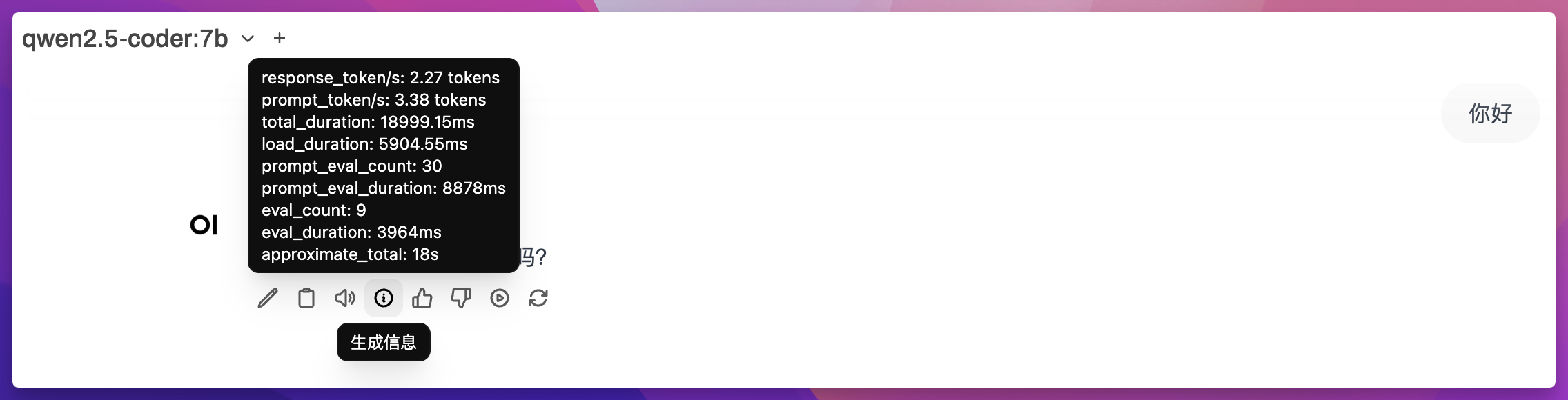

效果如下:

不过 7b 的模型对于 M1 Max 32G 内存的设备来说,负担还是太大了,只提问一个「你好」,回答花了 18 秒,每秒 2.27 token 数,速度太慢,并且 CPU 占用直接爆掉。

2025.01.13 更新|速度更快的解决方案

LM Studio 教程:在 MacBook M1 上运行通义千问 Qwen 2.5 模型

我的 Notion 课程

《Notion 搭建高能效率系统》

- 从「效率困局」到「生产力中枢」

- 用 18 个月打磨的 Notion 精进指南

- 助你在 7 天内掌握精英必备的效率神器

- 推出一年半,帮助近 6000 位学员精通 Notion

- 国内销量最高的 Notion 系统课程

- 小红书好评率超过 98%

详情介绍:点我

本站所有文章,除非特别说明或标注,均为本站原创发布。转载本文需附上本文链接,未经授权,禁止大篇幅复制、盗用、采集或发布本站内容至其他网站、书籍等各类媒体平台。